Das Leibniz-Rechenzentrum der Bayerischen Akademie der Wissenschaften (LRZ) ist das Hochschulrechenzentrum für die Ludwig-Maximilians-Universität (LMU), die Technische Universität München (TUM), die Bayerische Akademie der Wissenschaften sowie sonstige Wissenschaftseinrichtungen des Freistaates Bayern. Es erbringt IT-Dienstleistungen wie E-Mail, Internet, WLAN und VPN. Zusätzlich betreibt das LRZ Hochleistungsrechensysteme für die genannten Hochschulen sowie einen nationalen Höchstleistungsrechner, der zu den leistungsfähigsten Rechnern der Welt zählt und allen öffentlichen deutschen Forschungseinrichtungen zur Verfügung steht.

Diese High-Performance-Computing-Systeme (HPC) bilden den Kern, um reelle Probleme zu simulieren. Dadurch werden Kosten für Laborexperimente vermieden und nicht realisierbare Experimente erst ermöglicht. Beispielsweise werden Regenfälle simuliert, Überschwemmungen berechnet und damit aufgezeigt, welche Maßnahmen diese vermeiden können. Bei simulierten Windkraft- und Windräderfarmen kann deren Verteilung so berechnet werden, dass sie sich gegenseitig möglichst wenig beeinflussen.

Performance braucht Kühlung

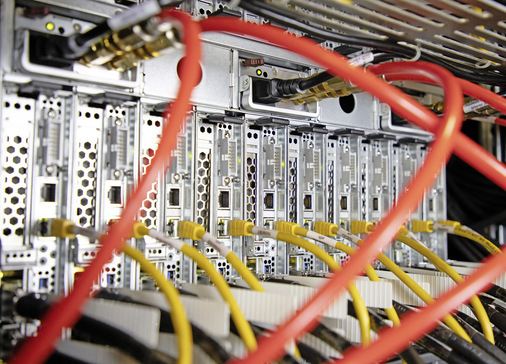

Aufgrund der eingesetzten Hardwareplattformen und typischen Workloads in einem HPC-System ist eine effiziente und leistungsfähige Kühlung der IT-Komponenten besonders wichtig. Standardisierte Architekturen für derartige Anforderungen kommen hier schnell an ihre technischen Grenzen. Im besonderen Fall des LRZ wurde zudem eine zusätzliche und neue Rechenkapazität benötigt.

Mit der Erneuerung sollte ein System geschaffen werden, das den Nutzern die Möglichkeit gibt, ihre Anwendungen für künftige Rechnerarchitekturen vorzubereiten. Mit dem Ziel, Energie zu sparen, wurde beschlossen, ausschließlich Wasserkühlung einzusetzen. Denn der Verzicht auf Luftkühlung steigert die Energieeffizienz deutlich: Typische Leistungszahlen (Energy-Efficiency-Ratios) für Luftkühlung liegen unter fünf, für Warmwasserkühlung über 20. Da nur noch ein Kühlkreislauf ohne mechanische Kühlaggregate benötigt wird, werden Komplexität und Installations- und Betriebskosten der Infrastruktur deutlich reduziert.

Schon bisher wurden am LRZ warmwassergekühlte Systeme eingesetzt. Allerdings waren die besonders hinsichtlich ihrer Effizienz bei der Kühlung der Komponenten verbesserungsfähig, was auch dem Alter der Systeme geschuldet war. Bereits 2011 baute das LRZ auf eine direkte Wasserkühlung seiner Systeme. Dabei wurden jedoch noch nicht alle Komponenten mit Wasser gekühlt, sondern hauptsächlich Netzteile, Netzkomponenten und Switches. Der Energieeintrag in die Umgebungsluft konnte nicht unter 15 Prozent gehalten werden. Vielmehr mussten bei den großen Systemen noch viele Kilowatt elektrische Leistung für die Luftkühlung eingesetzt werden.

Neuer Lösungsansatz

Zwar stammten schon die 2011 eingesetzten Systeme von Megware, allerdings ist bei der Wasserkühlung des Unternehmens inzwischen die vierte Generation im Einsatz. Die Abwärme aller Komponenten wird nun mit Direktwasserkühlung abgeführt. Dafür wurden gemeinsam mit Schäfer IT-Systems, einem Hersteller von maßgeschneiderten Netzwerk-, Serverschrank- sowie Rechenzentrumslösungen, bestehende Lösungen weiterentwickelt und Komponenten beispielsweise mit Cold-Plates umgerüstet.

Aktuell ist das System, das vollständig warmwassergekühlt arbeitet, nach Angabe des Herstellers weltweit einmalig. Es ist thermisch isoliert und vermindert somit den Wärmeeintrag in die Umgebung auf rund drei Prozent Abwärme. Den Rest erledigen Raumbefeuchtungs- respektive -entfeuchtungsanlagen. Zudem konnte das Temperaturniveau, bei dem die Wasserkühlung effizient arbeitet, angehoben werden. Damit wird das Heißwasser für Kühlkonzepte mit Zweitverwendungen, wie beispielsweise eine Gebäudeheizung, interessant. Auch beim LRZ wird das Kühlwasser für die Abwärmenachnutzung verwendet.

Anspruchsvolle Anforderungen

Bei der jüngsten europaweiten Ausschreibung 2017 kamen Megware und Schäfer IT-Systems mit dem System CoolMUC-3 zum Zug. Gefordert war eine vollständige Wasserkühlung aller Komponenten mit über 40 °C warmem Wasser, um das Cluster ganzjährig ohne energieintensive mechanische Kälteerzeugung zu kühlen. Bei der Entwicklung hatten zwei Aspekte Priorität: die thermische Isolierung der Racks, damit weniger Abwärme in den Rechnerraum gelangt, und eine möglichst hohe Temperatur des Kühlwassers, um die Abwärme effizient, zum Beispiel für Adsorptionskühlung, nachnutzen zu können.

Insgesamt gingen lediglich drei Bewerbungen ein, wobei nur Megware ein adäquates Kühlsystem anbieten konnte. Dieses HPC-System wurde 2018 in Betrieb genommen.

Schäfer IT-Systems stimmte in enger Zusammenarbeit mit Megware zunächst das Konzept und anschließend die entsprechenden Lösungen ab. Hohe Ansprüche gab es beispielsweise an den Wasserkreislauf und dessen gleichbleibende Qualität: Das Kühlsystem besteht aus relativ kleinen Strukturen, durch die das Wasser fließen muss. Deshalb muss es möglichst frei von Partikeln sein. Durch die Berührung mit dem Kühlmittel ist auch das genutzte Material der Komponenten entscheidend.

Das Ergebnis ist ein Rack, in dem sowohl Rohrleitungen für Wasser, ein Wärmeübertrager samt Pumpengruppe als auch ein Druckausgleichsgefäß integriert sind. Dadurch kann die Wärme aus dem Schrank abgeführt werden, ohne dass es mit dem Wasserkreislauf des Rechenzentrums in Berührung kommt.

Ein geschlossener Kühlwasserkreislauf bzw. die Trennung der Kreisläufe in Serverschränken und Rechenzentrum ist ein notwendiger Schritt: Kreisläufe in Datacentern unterliegen weniger strengen Anforderungen an die Wasserqualität. Integriert ist ebenfalls ein Touchscreen, der mittels entsprechender Sensorik und Schnittstellen alle Temperaturen im Inneren und Äußeren anzeigt. Das ersetzt derzeit gängige App-basierte Cloud-Lösungen, die seitens des LRZ aus Sicherheitsgründen keine Alternative waren. Das intelligente Rack bindet Werte in eine von Megware programmierte und verwaltete Managementsoftware ein. Dadurch ist ein Zugriff durch Administratoren auch von außerhalb möglich.

Fazit

Nach rund einem Jahr Betriebsdauer entspricht das HPC-System allen Erwartungen und Ausgangsanforderungen. Vor allem wurde bereits eine deutliche Energieeinsparung festgestellt.